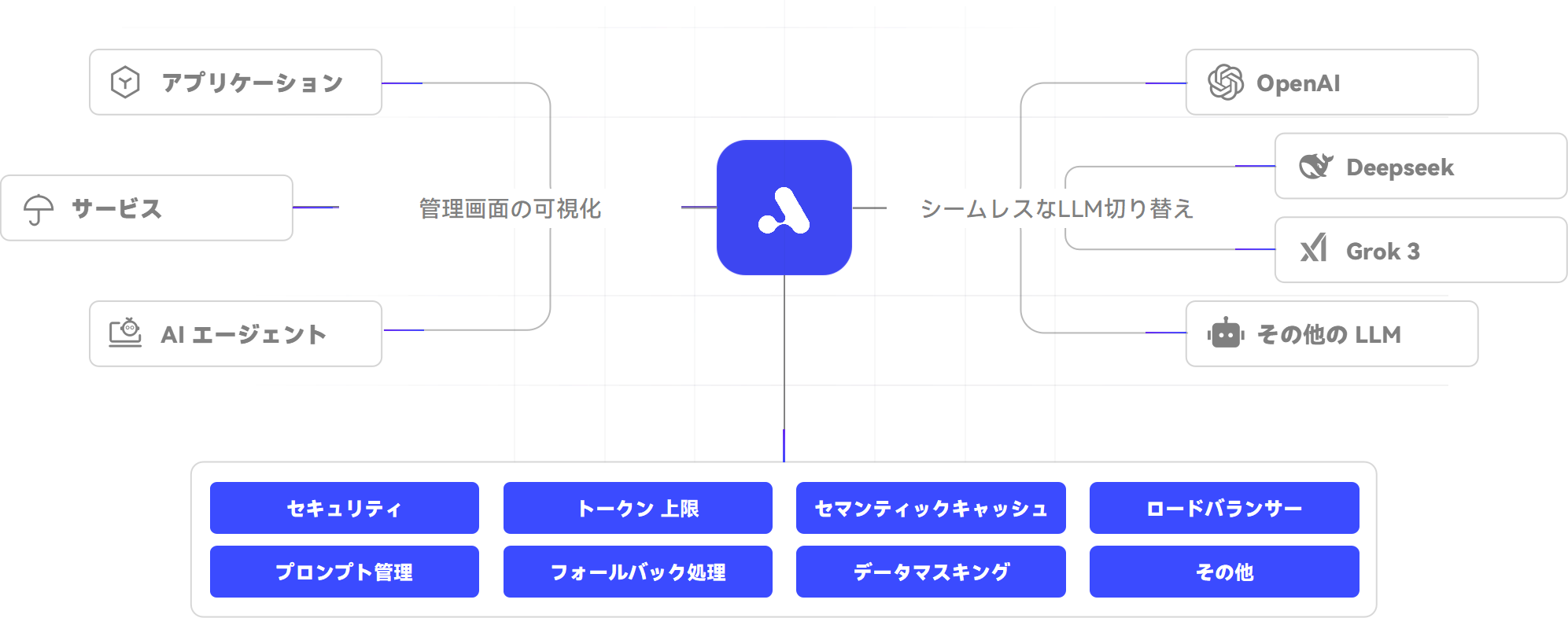

200 以上の人気 AI 大規模モデルを

統合したプラットフォーム

APIPark は今後もより多くの LLM との連携を進めていきます。もしご希望のモデルが未対応の場合は、ぜひ issue をご提出ください。優先的に対応させていただきます。

大規模言語モデルの

企業業務への迅速な導入を支援します

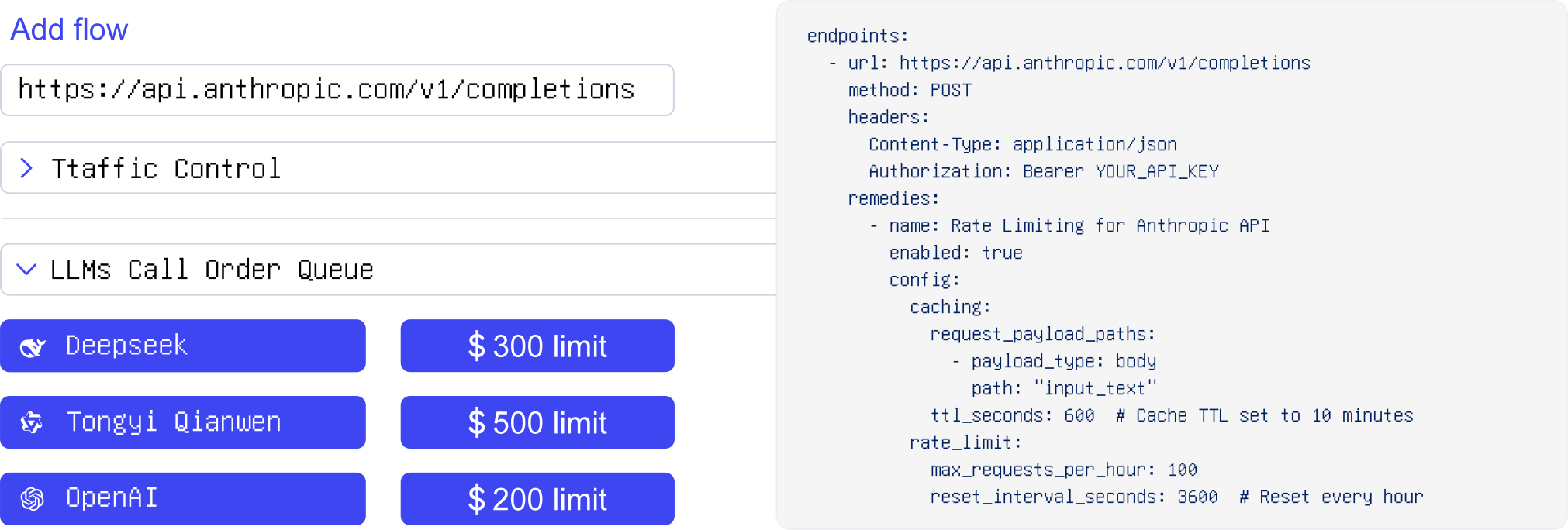

業務シナリオにおける

大規模モデルのトラフィックの細分化管理

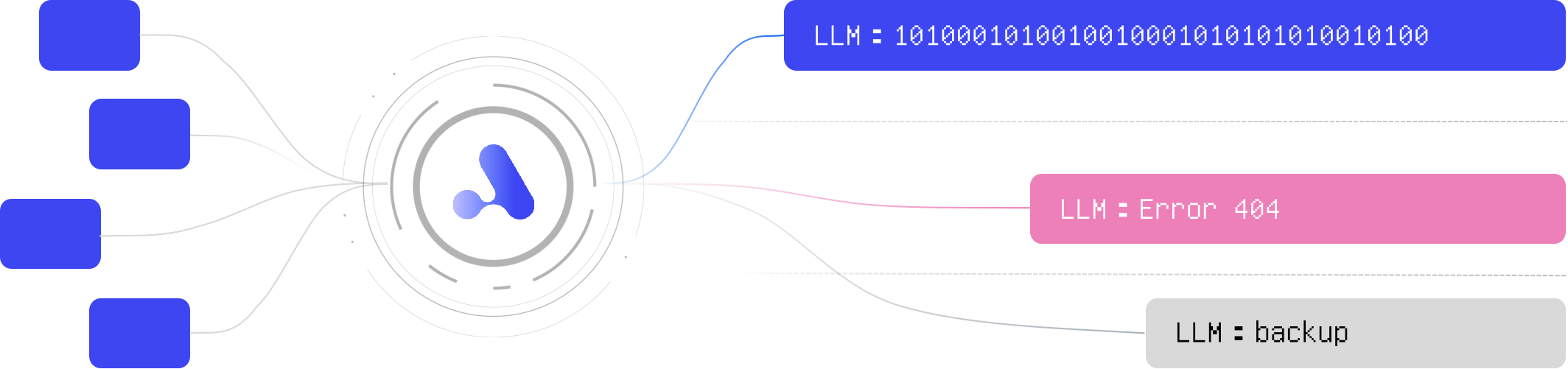

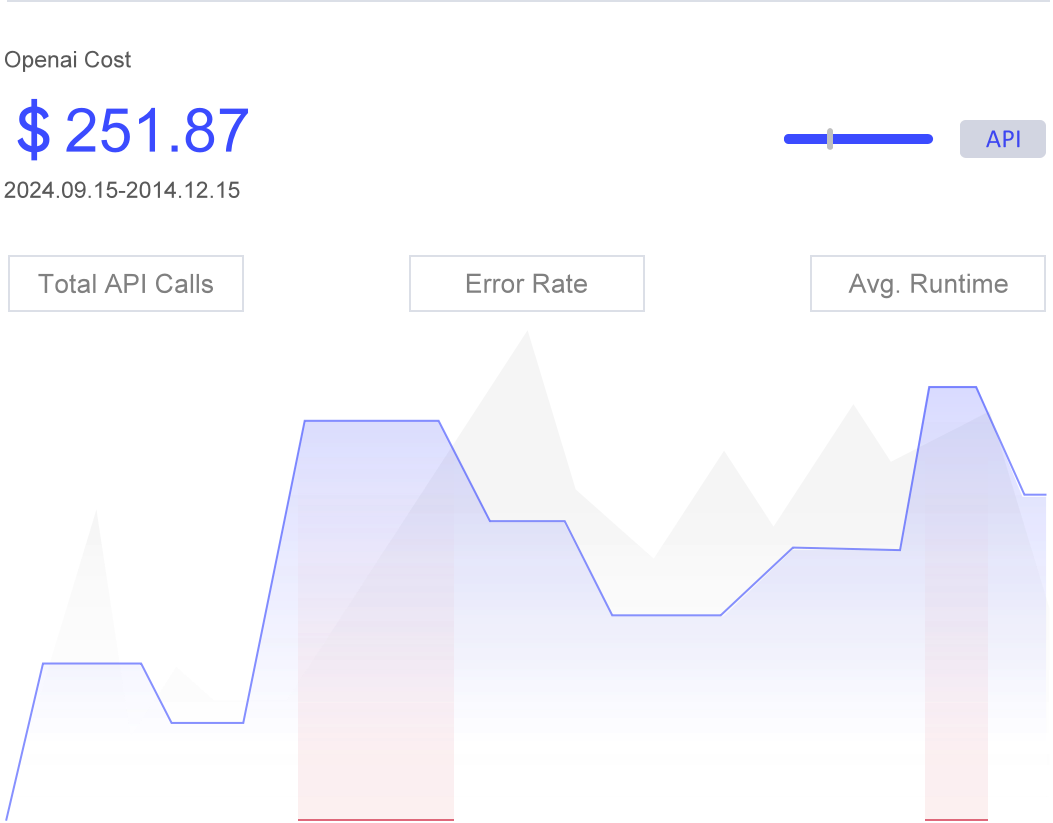

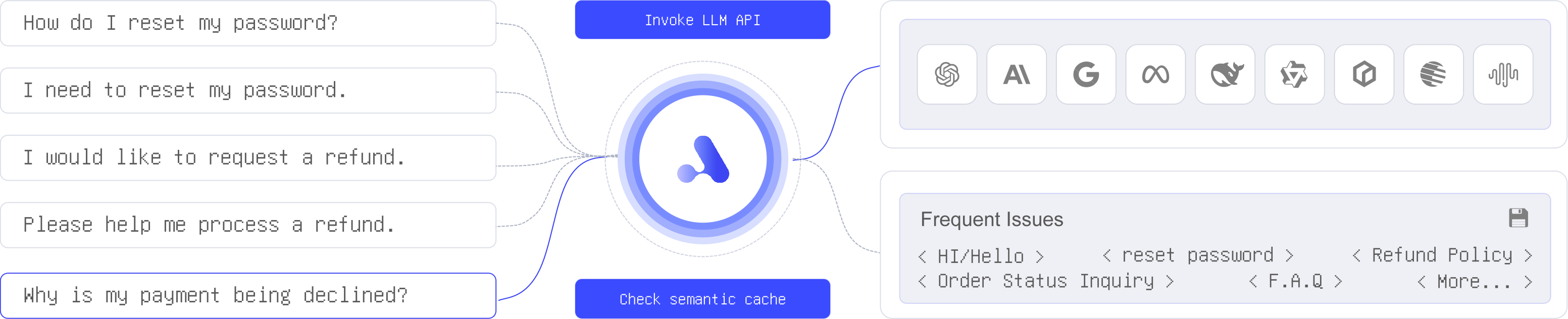

AI の応答速度を高め、

大規模モデルの利用コストを削減します

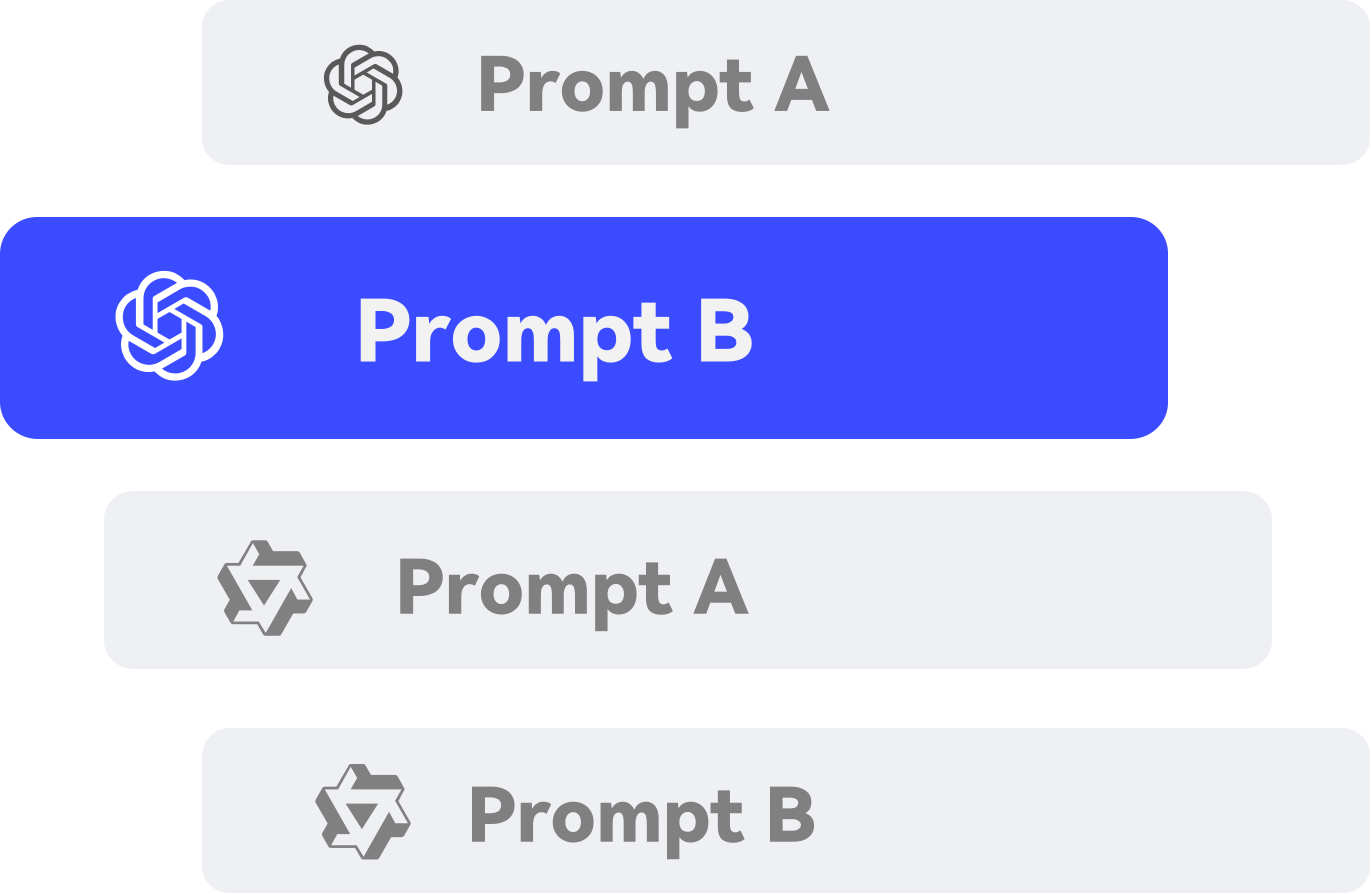

プロンプト管理を柔軟に設定し、

業務ニーズの変化に対応

APIPark × AI エージェントで、

AI ビジネスの活用と管理シーンを拡大

APIPark は今後も多くの AI エージェントプラットフォームと連携します。ご希望のプラットフォームがなければ、 issue をご提出ください。優先対応します。

たった一つのコマンドで

5分以内に専用のLLMゲートウェイとAPIポータルをデプロイ!

なぜAPIParkを選ぶべきですか?

APIParkはKongやNginxより優れたパフォーマンスを発揮し、高い同時接続数と大規模なリクエストを低遅延かつ高スループットで処理します。

シンプルなAPI、分かりやすいドキュメント、柔軟なプラグイン構造により、簡単にカスタマイズと迅速な統合が可能で、複雑さを軽減します。

既存の技術スタックに簡単に統合でき、人気のあるプラットフォームやツールと連携するため、システムの全面的な見直しが不要です。

組み込みのAPI認証、トラフィック制御、データ暗号化機能により、企業の業務アプリケーションのセキュリティとデータ保護を確保します。

F.A.Q

ご不明な点がありますか?

以下の関連質問をご参照ください。

LLMゲートウェイ(AIゲートウェイとも呼ばれます)とは、企業が大規模言語モデル(LLM)を効率的に管理するためのミドルウェアプラットフォームです。統合プロセスを大幅に簡素化し、複数のAIモデルに同時接続することを可能にします。さらに、LLMゲートウェイは包括的な管理機能を提供し、AIモデルの運用をより細かく制御することで、安全性と効果的な活用の両方を向上させます。

APIParkは、LLM(大規模言語モデル)ゲートウェイおよびAPIプラットフォームとして、LLMの呼び出し管理を簡素化し、APIサービスの統合を効率化します。LLMの使用状況を細かく制御できるため、コスト削減、効率向上、過剰使用の防止に貢献します。また、利用状況の詳細な分析機能も提供し、ユーザーがLLMの使用を監視・最適化することが可能です。

さらに、APIParkは内部および外部のAPIを強力なセキュリティとアクセス制御のもとで一元的に統合・管理できるプラットフォームです。スケーラブルな設計により、ビジネスニーズに応じた柔軟な対応が可能です。

LLMゲートウェイ(AIゲートウェイとも呼ばれる)は、企業が大規模言語モデル(LLM)を効率的に管理するために設計されたミドルウェアプラットフォームです。統合プロセスを大幅に簡素化し、複数のAIモデルに同時に迅速に接続できるようにします。さらに、LLMゲートウェイは包括的な管理機能を提供し、AIモデルの運用をより適切に制御することで、安全性と活用効果の両方を向上させます。