在现代科技的飞速发展中,API已经成为连接不同应用和服务的桥梁。尤其是在人工智能和大数据的背景下,API的应用更加广泛。而APIPark作为一个重要的API管理平台,其安全机制如何保障大模型调用的可靠性,成为了开发者和企业关注的焦点。本文将深入探讨APIPark的安全机制,如何在API安全、API开放、API Developer Portal和文心一言的场景下,保障大模型调用的可靠性。

API安全的重要性

API安全是确保数据传输和应用程序功能安全的关键。随着API的广泛应用,API攻击的风险也在增加。常见的API攻击方式包括SQL注入、跨站脚本攻击(XSS)、拒绝服务攻击(DoS)等。这些攻击可能导致数据泄露、功能失效,甚至系统崩溃。因此,API安全的重要性不言而喻。

APIPark通过多层次的安全机制来保护API调用的安全性。首先,它采用了OAuth2.0认证机制,确保只有经过授权的用户才能访问API。其次,APIPark提供了API密钥管理功能,帮助开发者对API的使用进行精细化的控制。此外,通过使用HTTPS协议,APIPark确保了数据在传输过程中的加密,防止数据被窃取或篡改。

API开放的挑战与机遇

API开放是推动技术进步和创新的重要方式。开放API可以促进外部开发者的参与,推动生态系统的发展。然而,API开放也带来了新的挑战,特别是在安全性方面。开放API意味着更多的访问者,这也意味着更多的潜在攻击者。

APIPark在API开放的过程中,通过严格的权限管理和访问控制来应对这些挑战。开发者可以通过API Developer Portal轻松设置访问权限,确保只有授权的用户才能调用API。同时,APIPark支持IP白名单和黑名单功能,帮助开发者限制和管理API的访问来源。

API Developer Portal的角色

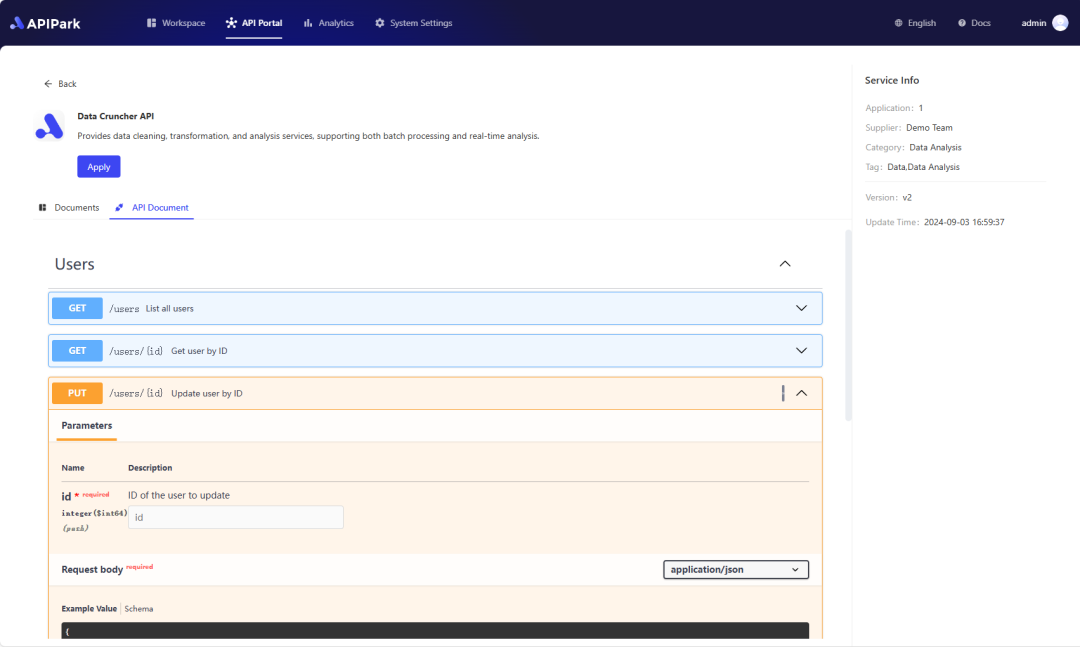

API Developer Portal是开发者与API交互的重要界面。它不仅提供了API文档和示例代码,还提供了丰富的管理功能。通过API Developer Portal,开发者可以轻松查看API的使用情况,管理API密钥和权限设置。

表格:API Developer Portal主要功能

| 功能 | 描述 |

|---|---|

| API文档 | 提供详细的API使用说明和示例代码 |

| API密钥管理 | 帮助开发者生成和管理API密钥,控制API的访问权限 |

| 访问统计与监控 | 提供API调用次数、响应时间等统计数据,帮助开发者监控API的性能 |

| 权限管理 | 支持对API的访问进行精细化权限设置 |

通过这些功能,API Developer Portal在API管理和安全中扮演了重要角色。开发者可以通过Portal设置访问策略,监控API使用情况,并根据需要调整API的访问权限。

文心一言与大模型调用的可靠性

文心一言作为一种先进的大模型,其调用的可靠性直接影响到应用的性能和用户体验。在调用大模型时,确保API的响应速度和稳定性是关键。APIPark通过多种机制保障大模型调用的可靠性。

首先,APIPark采用了负载均衡技术,将API请求合理分配到不同的服务器上,确保即使在高并发情况下,API也能稳定响应。其次,APIPark提供了缓存机制,对于频繁调用的API结果进行缓存,减少服务器的计算负担,提高响应速度。

此外,APIPark还支持API调用的重试机制。在网络波动或服务器故障的情况下,API调用可以自动重试,避免因偶然故障导致的调用失败。

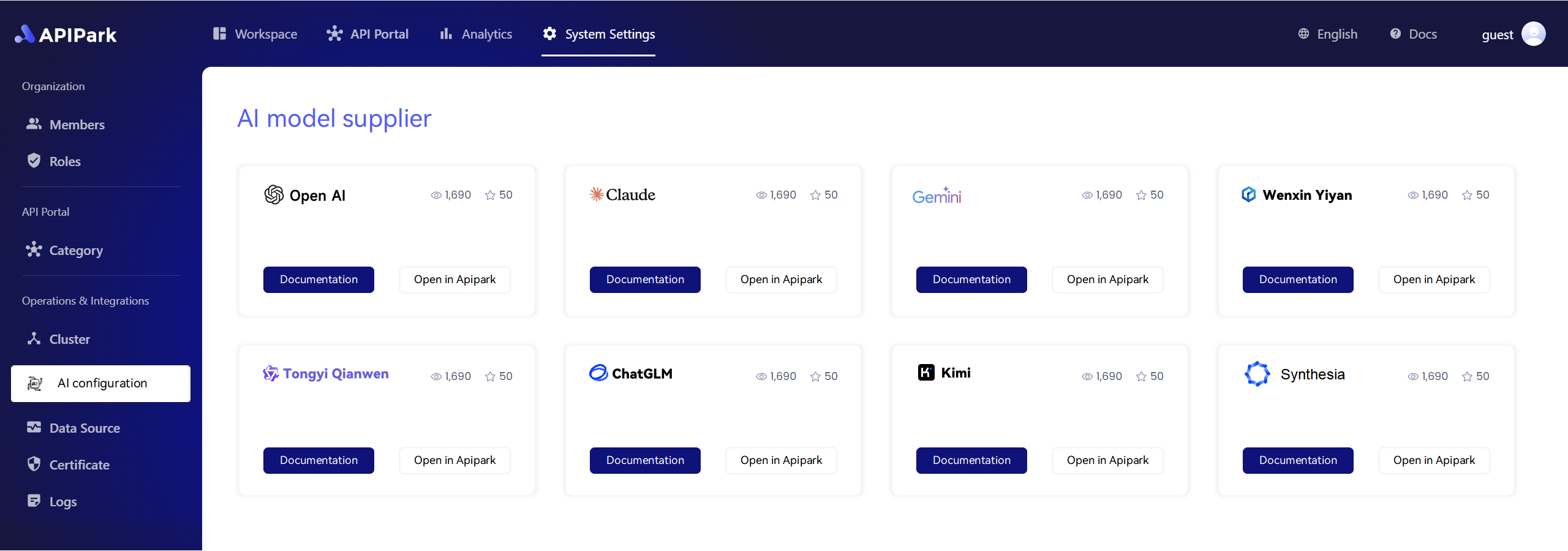

APIPark 是一个高性能的人工智能网关,在 APIPark 上您可以安全地调用全球最全面的大规模语言模型(LLM)API,包括 OpenAI、Anthropic、Mistral、Llama2、Google Gemini 等。现在就尝试 APIPark!👇👇👇

实现API安全的代码示例

以下是一个使用Python实现API安全调用的简单示例,展示了如何使用OAuth2.0进行认证:

import requests

from requests_oauthlib import OAuth2Session

# 定义API的基本信息

api_base_url = 'https://api.example.com/'

client_id = 'your_client_id'

client_secret = 'your_client_secret'

authorization_base_url = 'https://api.example.com/oauth/authorize'

token_url = 'https://api.example.com/oauth/token'

# 创建OAuth2会话

oauth = OAuth2Session(client_id, redirect_uri='https://your.redirect.uri/')

authorization_url, state = oauth.authorization_url(authorization_base_url)

# 打印授权URL

print('Please go to %s and authorize access.' % authorization_url)

# 获取访问令牌

token = oauth.fetch_token(token_url, client_secret=client_secret)

# 使用获取的令牌进行API调用

response = oauth.get(api_base_url + 'resource')

print(response.json())

通过这种方式,可以确保API调用的安全性,只有经过授权的用户才能访问API资源。

总结

在数字化转型的浪潮中,API的作用越来越重要。APIPark通过其完善的安全机制,为API的调用提供了强有力的保障。在API安全、API开放、API Developer Portal和文心一言等方面,APIPark都展现了其独特的优势。通过多层次的安全措施、灵活的权限管理和高效的调用机制,APIPark为大模型的可靠调用提供了坚实的基础。这不仅提升了应用的安全性和可靠性,也为开发者提供了更好的工具和平台,推动了技术的创新和发展。

🚀 您还可以在APIPark上发布您自己的AI API,让合作伙伴能够轻松访问。🤝 立即尝试APIPark!👇👇👇

如何在APIPark上调用Tongyi Qianwen大型模型API

步骤1:在5分钟内部署APIPark AI网关。

APIPark是基于Golang开发的,具有强大的产品性能和低开发及维护成本。您可以使用一行命令行轻松部署APIPark。

curl -sSO https://download.apipark.com/install/quick-start.sh; bash quick-start.sh

根据我的经验,您可以在5到10分钟内看到成功的部署界面。然后,您可以使用您的账户登录APIPark。

步骤2:调用Tongyi Qianwen大型模型API。

通过APIPark,企业可以轻松地将OPENAI大型模型集成到他们的产品和服务中,同时确保AI安全和高效性。